File Robots.txt là một trong những tệp quan trọng cần có trên Website. Vậy file Robot.txt là gì? Nhiệm vụ của file này trên Web như thế nào? Cách tạo file Robot.txt ra sao? Để hiểu tất tần tật về tệp tin quan trọng này thì mời bạn hãy cùng Xuyên Việt Media khám phá nội dung bài viết sau đây.

File Robots.txt là gì?

File Robots.txt là tập tin văn bản đơn giản có đuôi là txt và cũng là một file hỗ trợ nhà quản trị website cho phép hoặc không cho phép các Googlebot thu thập dữ liệu trên Web, index nội dung và cung cấp những nội dung đó cho những người dùng.

Tệp này có nhiệm vụ chủ yếu là quản lý lưu lượng truy cập của trình thu thập dữ liệu vào website của bạn và đây không phải là một cơ chế để ẩn một trang web nào đó khỏi Google.

Các thuật ngữ dùng trong tệp Robots.txt

Sau đây sẽ là những cú pháp được xem là những ngôn ngữ riêng của file Robots.txt. Hiểu rõ được từ lệnh trong bài file sẽ giúp bạn chủ động hơn khi cần gắn hoặc xóa lệnh theo ý muốn.

- User-agent: Phần này là tên gọi của các trình thu thập, truy cập dữ liệu web mà bạn đang hướng dẫn thu thập thông tin (thường là các công cụ tìm kiếm như: Google, Bingbot,…)

- Allow: Nếu bạn muốn báo với Googlebot rằng hãy đọc thông tin trên website của bạn thì hãy gắn Allow vào nhé.

- Disallow: Lệnh này được đưa ra khi chủ Web không cho phép các chú bot thu thập thông tin trên một bài viết, trang nào đó trên Website. Và 1 Disallow được sử dụng cho 1 URL, không dùng cho tất cả các trang trong Web, tức với bài viết nào mà bạn không muốn Googlebot quét qua thì gắn lệnh này vào.

- Crawl-delay: Thông báo cho các web Crawler biết rằng cần bao nhiêu giây để trình thu thông tin trước tải và thu thập nội dung trang.

- Sitemap: Đây là liên kết sitemap cho phép gọi vị trí bất kỳ sitemap XML nào được liên kết với URL này. Lệnh này chỉ dùng cho Google bot.

File Robots.txt hoạt động như thế nào?

Nhìn chung nhiệm vụ chính của file này đó là cào dữ liệu sau đó index nội dung để đáp ứng theo yêu cầu tìm kiếm của người dùng. Cụ thể công việc của nó bao gồm:

- Cào và quét dữ liệu.

- Index nội dung trên công cụ tìm kiếm.

Để tiến hành Crawl (cào) dữ liệu trên Web thì công cụ sẽ đi theo đường dẫn của những liên kết, cứ lần lượt như vậy nó sẽ thu được thông tin từ nhiều trang khác nhau. Quá trình cào dữ liệu này còn được gọi là “Spidering”.

Khi vào được website, việc làm đầu tiên của Googlebot là tìm kiếm file Robots.txt để thực hiện nhiệm vụ Crawl và index dữ liệu trên Web. Nếu trên file Robots.txt không có lệnh User-gent hoặc website của bạn thiếu mất tệp tin này thì các “chú bots” của Google sẽ quét và thu thập toàn bộ các thông tin có trên website.

THÔNG TIN THÊM: 8 phần mềm Facebook Marketing hiệu quả

Những cách tạo file Robots.txt cực đơn giản

Để giúp các chủ trang web quản lý được lưu lượng truy cập của những con bot của Google vào trang web thu thập thông tin thì các chủ website cần tạo file Robots.txt. Sau đây là những cách tạo file robots.txt cực đơn giản:

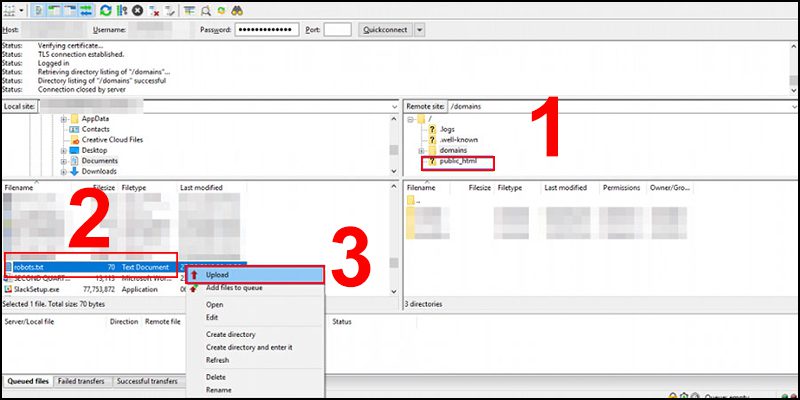

Upload file Robots.txt qua FPT sau khi tạo

Bạn có thể tạo file Robots.txt thủ công bằng phương pháp tạo rồi upload file Robots.txt qua PDF. Bạn có thể thực hiện theo các bước sau:

- Bước 1: Mở notepad hoặc Textedit có sẵn trong máy để tạo file Robots.txt WordPress

- Bước 2: Sau đó mở FPT > nhấp chọn thư mục public_html > chọn file Robots.txt > Nhấp Upload.

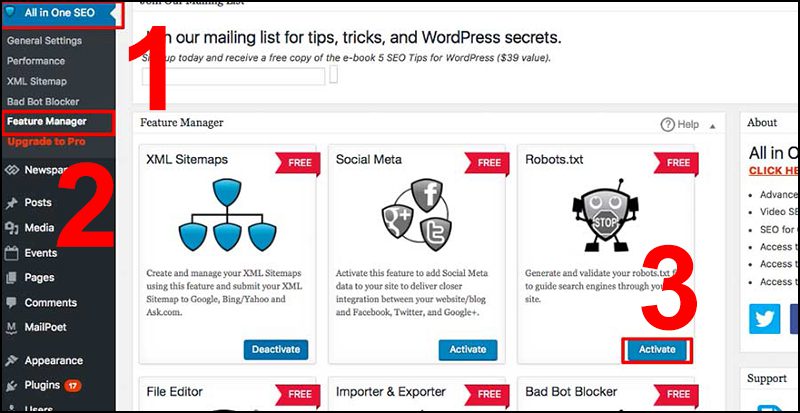

Tạo tệp robots.txt bằng Plugin All in One SEO

Với plugin All in One SEO cho phép bạn tạo hoặc sửa file Robots.txt một cách khá dễ dàng, đây cũng là một plugin tiện ích cho WordPress đơn giản và dễ sử dụng.

- Bước 1: Để tạo được file Robots.txt WordPress, đầu tiên bạn bạn cần tải plugin All in One SEO. Nếu chưa có hãy nhấn vào đây để cài đặt nhé.

- Bước 2: Chọn All in One SEO > chọn mục Feature Manager > Nhấp vào mục Active và chọn file Robots.txt

- Bước 3: Đến đây bạn có thể tạo hoặc tùy chỉnh file Robots.txt theo ý muốn.

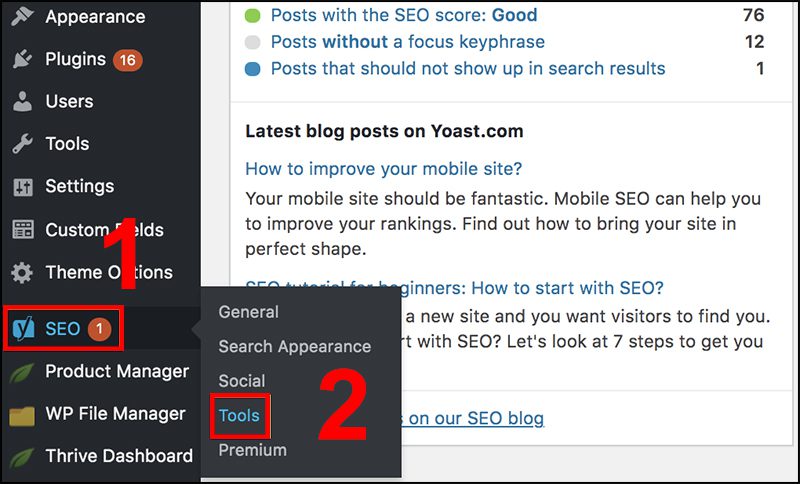

Sử dụng plugin Yoast SEO để tạo file Robots.txt

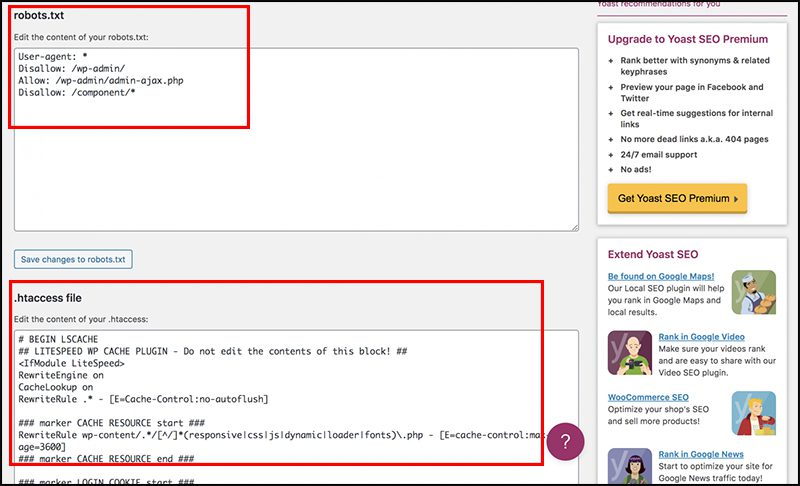

Nếu bạn muốn chỉnh sửa hoặc tạo File Robots.txt thì plugin Yoast SEO quen thuộc vẫn có thể giúp bạn làm “chuyện ấy”. Từng bước tạo file Robots.txt bằng plugin Yoast SEO như sau:

- Bước 1: Cũng tương tự như trên, để sử dụng Plugin trên WordPress bạn hãy vào kho plugin tìm kiếm Yoast SEO và cài đặt. Nếu đã cài đặt thành công thì vui lòng bỏ qua bước này nhé.

- Bước 2: Phía bên trái màn hình, click vào SEO > Chọn mục Tools > Chọn File Editor.

- Bước 3: Tiếp đó bạn sẽ thấy mục Robots.txt và htaccess file. Đến đây thì bạn có thể tùy chỉnh file theo yêu cầu của mình.

Tại sao các bạn cần tạo file Robots.txt?

Thiết lập file Robots.txt WordPress cho website của bạn giúp kiểm soát được truy cập của các con bots đến những khu vực nhất định trên web. Việc tạo file Robots.txt mang lại nhiều lợi ích như sau:

- Ngăn chặn những nội dung trùng lặp trong website.

- Giữ một số phần của trang ở chế độ riêng tư.

- Giữ kết quả các tìm kiếm nội bộ không hiển thị công khai

- Chỉ định vị trí sơ đồ trang web (Sitemap)

- Dùng lệnh Crawl-delay nhằm chỉ định độ trễ thu thập dữ liệu để ngăn máy chủ không bị quá tải khi trình thu thập dữ liệu tải nhiều phần trong cùng một lúc.

Lời kết

Vừa rồi là toàn bộ thông tin liên quan đến tệp tin Robots.txt mà Xuyenvietmedia.com muốn chia sẻ đến các bạn. Mong rằng qua bài viết này bạn giúp bạn hiểu được File Robots.txt là gì và có thể tự tạo file Robots.txt cho website của mình nhé